(1) データ解析技術の進展とロボットへの応用

昨今重要性を増してきているデータ解析技術については、目的や手法等に応じて様々な分野がある。例えば、人間と同じように様々な情報を元にコンピューターが学習し、その傾向等を分析する「機械学習」、人間が入力したゆらぎのある文章を理解する「自然言語解析」、人間が話しかけた声を解析しその内容を判別する「音声解析技術」、画像等から何が描かれているか判別する「画像解析技術」、様々な情報を元に現状や将来を予測する「推論技術」などがあげられ、それらを組み合わせ発展させることで、人間的な会話や動きができるロボット技術にも繋がっている。

ア 重要性が増すデータ解析技術

(ア)スマートフォンやSNS等に活用されるデータ解析技術

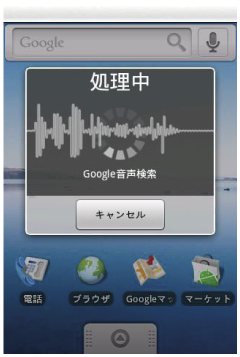

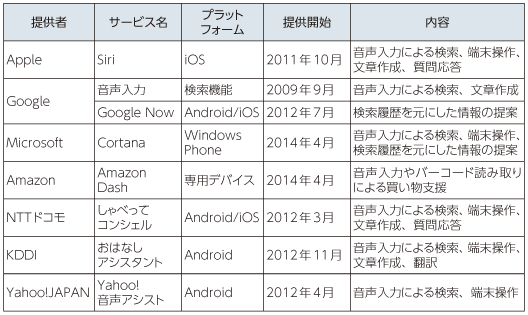

データ解析技術は、昨今普及が進むスマートフォン上での新たなサービスとしても身近になりつつあり、その活用例として、音声解析技術を用いたパーソナル・アシスタント(知的エージェント)などのUI(ユーザーインターフェイス)が挙げられる。パーソナル・アシスタントは、2009年からAndroid OSではスマートフォンに親和性の高い音声での検索機能が搭載されたことがきっかけとなり、新たな検索サービスへの入口が生まれ、その流れを受けAppleも2011年10月に、iOSの機能として「Siri」の提供を始めるなど、海外及び我が国の事業者でもスマートフォンの普及に伴い各社これら解析技術を活用したサービス導入が進んでいる(図表4-1-3-1、図表4-1-3-2)。

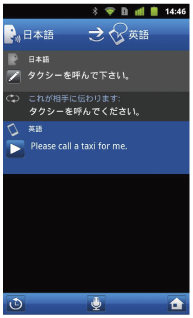

また、それらを発展させ入力された音声を元に海外の言語に翻訳して返答する自動翻訳機能もスマートフォンアプリ等に登場してきており、SNS上の写真等から誰が写っているかを判別する画像解析技術等も実用化されている。

A Apple「Siri」

SiriはAppleが2010年4月に買収した企業で、元はSRIインターナショナル(スタンフォード研究所)から独立したベンチャー企業である。2011年10月に発売されたiPhone 4SからiOSの基本機能として提供されており、音声から言葉を認識するだけでなく、これによって端末機能を操作することができる。代表的な動作の例としては、天気予報やスポーツの試合、レストランなどの検索結果を返すことができる。加えて、端末内のアプリケーションもこの操作のみで起動させることができ、メールやiOSと連携しているFacebook及びTwitterにおいては、音声で入力した文章をそのまま送信することも可能となっている。

「Siri」はそれまでの音声認識機能と比べて高い認識率をもち、人間味のある返答内容が特徴である。これには、マイクに入力された音から言葉を認識する音声認識と自然言語処理、それに対する出力の判断モデル(結果の提示方法)など、機能ごとにデータ解析技術が用いられている(図表4-1-3-3)。

B 我が国通信事業者等における主な音声認識サービス

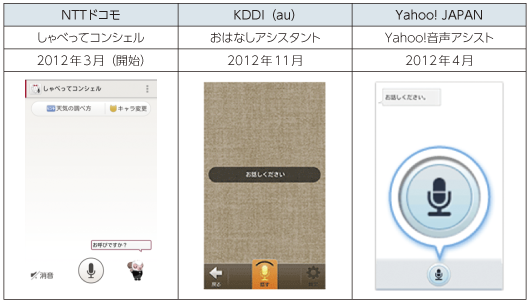

我が国においても、通信事業者がスマートフォン向けに音声認識サービスを各社導入している(図表4-1-3-4)。

NTTドコモは2012年3月よりスマートフォン向けに音声認識に対応した「しゃべってコンシェル」を提供しており、端末に話しかけることで、音声認識をクラウド側で行い、自社のポータルサイトである「dメニュー」の検索結果を返したり、アプリケーションの起動などの端末操作を行ったりすることが可能となっている。また、その他にも同社では2012年11月より、音声通話中に日本語と3か国語との翻訳を行う、「はなして翻訳」というサービスも提供している。

KDDIも2012年11月より「おはなしアシスタント」を提供しており、音声によって電話発信、メール作成などの端末操作や、天気予報や地図検索、各種ウェブ検索機能などが利用できる。加えて、食事などのライフログを音声によって簡単に記録することができるほか、2013年7月からは同サービス内にて自動翻訳機能も提供している。

Yahoo! JAPANにおいても2012年4月から「Yahoo!音声アシスト」を提供しており、音声認識によってAndroid対応携帯電話のアプリケーションを操作したり、別の「Yahoo!ブラウザ」アプリケーションと連携してブラウザ内の文字を読み上げたりすることができる。また、デンソーの「ARPEGGiO」と連携し、カーナビを操作することができ車内でのフリーハンドによるカーナビ利用も実現している。

C 成田国際空港「NariTra」

成田国際空港はスマートフォンアプリの「NariTra」を2011年12月から提供している。

「NariTra」は利用者がスマートフォンに向かって話した音声を認識し、翻訳した結果を音声合成して出力することで、外国人との対面会話を支援する翻訳アプリである。空港や観光地などの固有名詞のデータベースを充実させることで、言語の異なる空港利用者間のコミュニケーションをサポートしている。4か国語(英語・中国語・韓国語・インドネシア語)と日本語間の音声翻訳に対応しており、上記4か国語にタイ語、フランス語、スペイン語を加えた7か国語と日本語間のテキスト翻訳にも対応している(図表4-1-3-5)。

翻訳にはNICT(独立行政法人情報通信研究機構)が開発した多言語音声翻訳エンジン28が利用されている。この翻訳エンジンは平均7語程度の短文を精度よく翻訳することができ、利用事例を機械学習することでその精度を高めていくことができる。NICTの英語認識技術は2012年、2013年のIWSLT29における技術コンペで2年連続での最高精度を達成している30。

D Facebook「DeepFace」

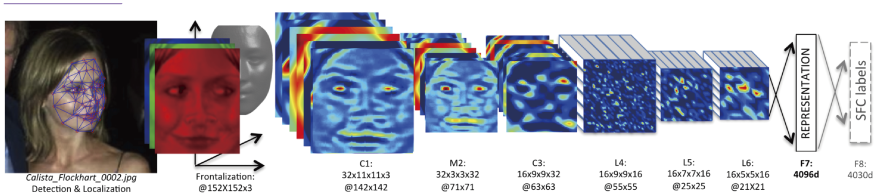

Facebookは、画像を解析して人物を特定する顔認識技術にも力を入れており、過去の画像を元に投稿された画像に対して自動でユーザ名のタグ付けを行う「Tag Suggestions」31を2010年7月に提供を開始したほか、2012年4月には写真共有サービスのInstagram、同年6月には顔認識技術のFace.comを相次いで買収している。その後、2013年12月には人工知能研究所を設立し、2014年3月に発表した論文では、97.25%という高い認識率の、人間と同程度に個人の顔を認識することができる技術「DeepFace」を開発したとしている。顔認識自体はデジタルカメラや顔認証システムでも実用化されているが、真正面を向いているなどの認識するための条件があったが、「DeepFace」は画像をそのまま学習していくのではなく、画像から3次元の顔の形状を推定し、それを学習させることによって個人を特定する特徴を自ら生成している32(図表4-1-3-6)。

(イ)データ量の増大とデータ処理能力の向上

A ビッグデータ、Internet of Things

このようにデータ解析技術が昨今注目を集めているのは、我々を取り巻くICT環境が変化してきたことも要因となっており、その一つに第3章でも述べたビッグデータがあげられる。インターネットには膨大な情報が日々流通・蓄積されているが、活用されている情報はまだ一部であり、それに対してどのような解析を行うかという指示はデータサイエンティスト等の人間が自分の経験等に基づいて考える必要がある。しかし、ビッグデータは人間が把握できる限度を超えた情報の塊であり、Internet of Things(モノのインターネット)とも言われるようにPCやスマートフォン以外にもM2Mなど膨大な端末が今後増加しインターネットに接続されることにより、そのデータ量は爆発的に増大することが見込まれており(図表4-1-3-7)、その量と複雑さへの対応速度と分析能力を得るツールとしてデータ解析技術が求められている。

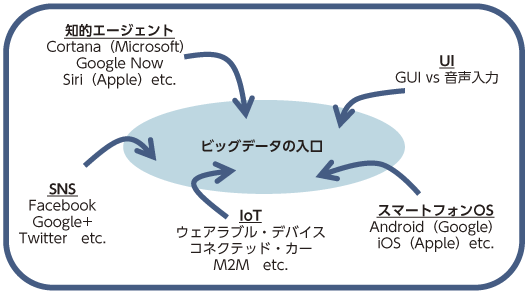

このような技術が今後更に高度化することで、膨大なデータの集合から、何らかの重要な傾向やパターンを抽出できるようになれば、インターネットを活用してビジネスを行う企業にとっては、新たなデータ解析技術を得るだけでなく、広告など現在のビジネスを最適化することで更なる収益増加が期待される。さらに、パーソナル・アシスタント等の新たなインターフェースはライフログやビッグデータの出入口ともなるプラットフォームであるため、これを押さえるべく、前述(ア)でも取り上げたOTT34とよばれる企業等が技術開発の先陣を争っているところである(図表4-1-3-8)。

B コンピューター性能の向上

コンピューターの計算能力の向上も解析技術の進展に大きな影響を与えている。コンピューターはムーアの法則として知られるように、1.5〜2年でその計算能力(トランジスタ数)が2倍になっており急激な速度で性能が向上している35(図表4-1-3-9)。

a IBM「Deep Blue」「Watson」

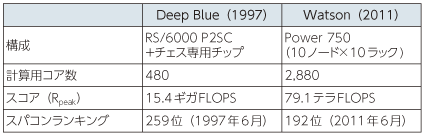

その一例として、米国IBMが開発したスーパー・コンピューター「Deep Blue」はチェスの世界チャンピオンに挑戦し、1997年5月の対局で初めて勝利した事例が挙げられる。「Deep Blue」はチェスというルールの中で有限の戦局から最善の一手を選択するというものだが、1秒あたり2億パターンの指し手を計算できるようになったことが、人間のチャンピオンに勝つ結果に貢献したと言われている37。

また、2011年2月には同社のコンピューター「Watson」が米国のテレビ番組「Jeopardy!」のクイズに挑戦した。このクイズ番組は問題が読み上げられると同時にモニタにもその全文が表示され、早押しによって回答する形式だが、「Watson」には特別に問題の提示と同時にテキストデータの問題が送られ、これを処理して、実際に物理的なボタンを押すことで回答した。その際、「Watson」は事前に百科事典などの百万冊分のデータを学習した上で、音声認識や画像認識は行わず自然言語理解と回答の判断に特化した結果、出題されたクイズに対し人間より早く回答し、2人の歴代チャンピオンに勝利した(図表4-1-3-10)。

なお、「Watson」のベースとなっているコンピューター「Power750」の能力は当時のスーパー・コンピューターランキングで192位38にあたり、本事例は世界1位を争うようなコンピューターでなくとも与えられた課題に対して高い成果を得ることが可能となった一例である(図表4-1-3-11)。

b コンピューター将棋

日本の将棋もチェスと同じく、指し手の判断以外に運の要素が入らず、すべての手順が公開されるゲームであるため、古くからコンピューターを用いた勝つためのアルゴリズムの研究がなされてきた。しかし、歴史的にも普及が日本国内に密着している点や駒を再利用するルールの複雑さから、コンピューターによる研究の歴史も1970年代頃からと比較的新しく、チェスに比べコンピューターが人間に勝利するのは難しいとされてきた。

しかし、2010年代に入ってから人間との公開対局において、頻繁に勝利を収めるようになり、2010年10月には現役女流棋士に、2013年3月には現役プロ棋士に初めて勝利した。これは複数のコンピューターを連結することで計算能力が向上した成果もあるが、もう一つの要因として、将棋は前述のとおり全ての棋譜が公開されるゲームであるため、過去のプロ棋士の対局データをコンピューターが機械学習することで、勝率の高い指し手の特徴を自ら学び、判断できるようになったことが挙げられる。

さらに、2014年3月にはドワンゴと公益社団法人日本将棋連盟が主催する「第3回電王戦」が開催された。同大会ではコンピューター将棋とプロ棋士の対戦が5回戦まで行われ、コンピューター将棋が4勝1負で2年連続勝ち越している40。今回よりコンピューター将棋のハードウェアが市販されるパソコンに統一されたが、コンピューター将棋の優位は変わらなかった41。また、対局ではデンソー製ロボットアーム「電王手くん」が初めて用いられ、将棋ソフトウェアの計算結果により、アームについているカメラを用い、将棋の駒を画像認識で識別し、コンプレッサーで吸着することで個々の駒を移動させた(図表4-1-3-12)。

イ データ解析技術の歴史と人工知能(AI42)の関わり

前述のSiri等に代表されるような人間的な反応を示すUIは、過去を振り返ってみるとAI(人工知能)とも呼ばれる技術開発の延長にある。UIは20世紀中ごろの初期の研究では、人間のような知能を持つコンピューターが簡単な命令で作業を実行するというAI(人工知能)のアプローチと、コンピューターはあくまでもツールに過ぎないとするIA(知的増強)43のアプローチに分かれており、後者のIAのアプローチは、マウスやGUIなどコンピューターを現在のように一般家庭にまで普及させるための基礎を築いてきた。

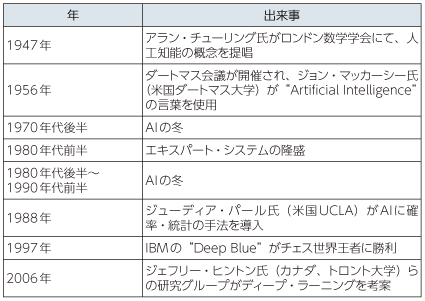

一方、前者AIのアプローチは1956年開催のダートマス会議44に向けた提案書に「AI」という言葉が初めて記載され、同会議でAIという研究分野が確立されたとされている45。しかし、人間のように優れた課題解決能力を実現しようとしたものの、プログラムで事前に設定しておいた規則を元に結果を返す当初の手法では、発生頻度の低い例外的な事象等への対応が難しかった。そのため、政府や企業の研究開発予算も縮小していき「AIの冬」ともよばれる山谷のある歴史を半世紀に渡り経ることとなった(図表4-1-3-13)。

こうしたAI研究を取り巻く状況の中で、2000年代に新たな成果が表れたのが、人間の学習能力を再現する機械学習という研究分野における「ニューラル・ネットワーク47」という手法である。人間は学習を行うことによって、脳の神経細胞(ニューロン)のネットワークを絶えず変化させ学習した内容を記憶したり応用したりできるようになるが、その概念をAIに組み込み、データの特性に合うように計算上の人工ニューロン(ノード)のネットワークを変化させ、計算を最適化していく手法である。

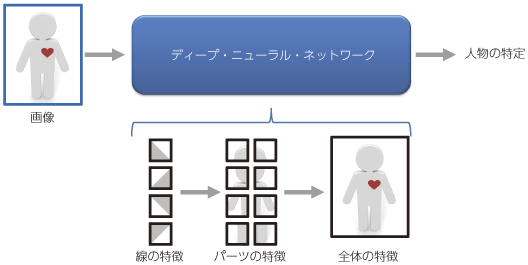

そして、2006年にカナダのトロント大学などの研究グループが、これを応用し「ディープ・ラーニング」という革新的な手法を提案した。この手法は、何層にも重なるニューラル・ネットワークを用い、データの集合から段階的に特徴を抽出することで、最終的にデータ全体を定義できるような特徴を効率よく探し出すことができる仕組みであり、この仮説は元々脳の視覚野などにおける研究成果であったが、あらゆる脳の領野に共通する仕組みと考えられている。また、私たちの脳が特定の情報に対してごく一部のみしか動かないようにすることで効率を上げているように、同様のアルゴリズム48を用いて計算の省力化を図っていることも特徴である(図表4-1-3-14)。

その後、このディープ・ラーニングは、2012年6月にスタンフォード大学及びGoogleとの共同研究で一つの成果が確認された。1,000台のクラスタ・マシンの上49で、YouTubeの動画からランダムに抽出した1,000万枚の画像を用いて3日間をかけて教師なし学習を行った結果、人や猫の顔に強く反応する人工ニューロンを作ることができたというものである。これは、人間が事前に人や猫の顔の画像をまとめたり、画像にラベルを付けたりすることなく、AIが自律的に認識性能の高い機械学習を実現できた例である50(図表4-1-3-15)。

ウ ロボット技術への応用

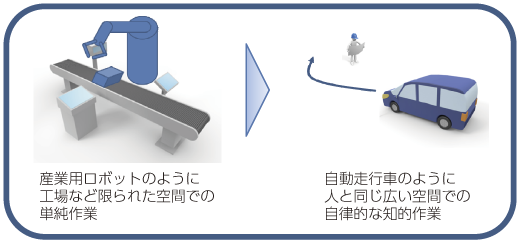

これらデータ解析技術はロボットの制御にも必要な技術であり活用が広まりつつある。これまでのロボットは枠組みの定まったラボ環境や工場などの特定の場所で、単純作業を繰り返すものだったが、特に研究開発が進んでいる自走するロボットは人間と同じ外部環境の中で、あらゆる周囲の情報から必要な動作を決めなければならない。

例えば、自動車メーカーは後述する自動走行車の開発に取り組んでいるが、走行中の周囲で起こるイレギュラーな状況にも対応できる安全な仕組みとともに、勝手に都市交通に渋滞を引き起こすことのないよう、車の運転において人間と同じレベルの判断能力を実現するための研究開発が行われている(図表4-1-3-16)。

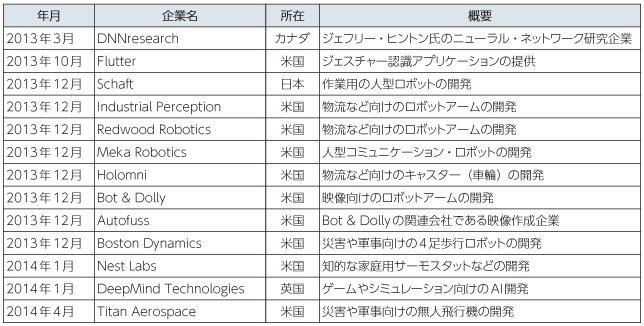

また、米国Googleが2013年に後述するSchaft社を含む複数のロボット関連企業を相次いで買収したことも、この分野への関心を引き付ける一端となっている(図表4-1-3-17)。

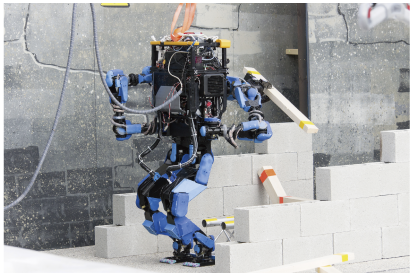

(ア)災害探索用レスキューロボット:米国DARPA「ロボティクス・チャレンジ」

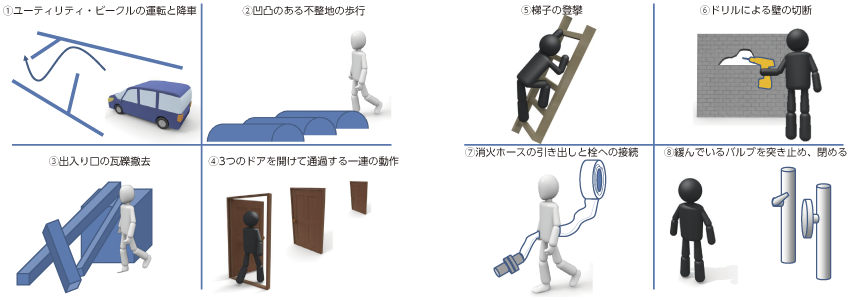

2011年の東日本大震災では福島第一原子力発電所にレスキューロボットが実際に投入され、被害状況の確認など災害現場での対応に貢献した。この教訓から米国DARPA(国防高等研究計画)では災害現場で人間と同じ作業が可能なロボットを実現することを目的とした「DARPAロボティクス・チャレンジ(DRC)」を開催し、2013年12月のトライアルには16チームが参加し、8つの課題に対応した(図表4-1-3-18)。

参加チームはDARPAが貸し出すロボットのソフトウェアのみを開発するチームと、ソフトウェアと共にハードウェアを自ら用意して参加するチームがあった。トライアルでは主に遠隔操作によって課題への対応が行われたが、災害現場では無線の環境が十分でないことも想定されるため、会場の無線の通信速度が限定されるなど、ある程度ロボット側での自律的な制御が求められ、日本から参加したSchaft社が開発した高さ1.48m、重さ95kgの2足歩行ロボット「S-One」は、動きの正確さだけでなく、周囲の状況を認識する速さに優れていたことが評価され同トライアルを1位で通過している53(図表4-1-3-19)。

同社はDRCに参加するため2012年5月に創業したベンチャー企業であり、このロボットは1998年に当時の通商産業省が始めた「人間協調・共存型ロボットシステム研究開発」による成果として、2002年に川田工業、産業技術総合研究所、安川電機、清水建設が共同開発した「HRP-2」がベースとなっており、同大会においては、日本のロボティクス技術の高さも伺える結果となった54。

(イ)身体機能を改善・補助・拡張するサイボーグ型ロボット:CYBERDYNE(日本)「HAL」

「HAL」は医療・福祉や重作業に用いるために開発された世界初のサイボーグ型ロボットで、利用者の筋力が弱い場合や筋肉を動かせない場合でも、その動作をサポートする。これには2つの仕組みがあり、一つは「サイバニック随意制御システム」と呼ばれるもので、運動時に脳から神経を通じて筋肉へと送られる微弱な生体電位信号を皮膚表面から読み取って解析し、その信号を元にパワーユニットを制御することで該当部位の運動をアシストし、利用者が意図した動作を実現する。信号が上手く伝達しない疾患等の場合には「サイバニック自律制御システム」と呼ばれる、人の運動のデータベースを元に適切な動作を再合成しパワーユニットを制御するシステムによって、スムーズな運動を実現する(図表4-1-3-20)。

筑波大学の山海嘉之氏が1991年より人とテクノロジーの一体化技術についての原理開発など、基礎的な研究を始め、2004年に大学発ベンチャー企業のCYBERDYNEを設立した。2010年に福祉用「HAL」の現行モデルの国内レンタル販売を開始し、2013年には医療用「HAL」が欧州で医療機器認証を取得し、HALによる治療がドイツで公的労災保険の適用を受けており、2013年12月時点で日本国内とドイツで計400台が稼働している。

エ データ解析技術における今後

ここまで述べたとおり、先進的なデータ解析技術は既に多くの製品やサービスに活用されつつある。また、米国で2012年に実施された分子活性予測のコンテストではディープ・ラーニングを用いたチームが優勝するなど、画像や音声といった分野に限らず、その応用による成果が出始めている。なお、このコンテストの優勝者は、化学の知識による事前の認識器のパラメータ調整は行わなかったにもかかわらず、従来の手法に勝る成果を出している57。これはすなわち、これまで専門的な知識を持った人間にも難しかった課題を、コンピューターによって誰しも解析できるようになることを示しており、薬学や医療などの分野で人々の健康や福祉等に役立つ新たな発見も期待される。

また、SaaSとしてもこれら技術は提供され始めており、一般的な企業がデータ解析を専門とする企業の技術を借りることもできるようになっている。例えば、米国ベンチャー企業であるNumenta社が提供するプラットフォーム「Grok」は、従来のような日次のバッチ処理ではなく、リアルタイムにストリーミング・データを機械学習で分析することで、WEBサービスなどに起こる変化をすぐにとらえることができる58。

加えて、IntelやQualcommなどのチップセットベンダ等のハードウェア産業でも研究開発が行われている。これは、これまでにも述べてきたとおり膨大な計算量を処理するためには、それを支える高性能な半導体チップが必要になるためである。各社はニューロモーフィック・チップと呼ばれるニューラル・ネットワークの計算に特化した補助演算装置を研究開発しており、将来的にはスマートフォン等にも搭載して、リアルタイムのデータ解析処理を実現しようとしている。このように、データ解析技術はICT産業全体に係る基盤技術となり始めている。

我が国においては、超高齢社会に向けて生活環境をICTによって整備していく必要があり、製品やサービスが高機能化する中、複雑な操作が受け入れ難い環境が生じつつあり、誰でも容易に製品やサービスを使えるようにすることが求められている。医療・介護の現場では、ロボットが介助などの作業を補助していくことも考えられ、介護向けロボットの国内市場は2012年の1.7億円から2020年には349.8億円にまで拡大すると予測されている。(図表4-1-3-21)。

こうした課題に対応できるのがデータ解析技術及びAIにもつながるUIの改善であり、人が製品やサービスに合わせる時代から製品やサービスが人に合わせる時代になることが期待される。加えて、将来の高齢者はICTを活用している今の現役世代であり、生活の中で発生する様々なライフログを元に、利用者の人となりや利用の仕方に合わせた処理を行うことで、今後の超高齢社会の課題をサポートしていくことも期待される。

28 NICTが提供した翻訳アプリ「VoiceTra」は、2010年7月から2013年3月まで提供され、公開以来ダウンロード数が857,257件(2013年3月末時点)に達し実証実験の当初目的である、音声翻訳システムの性能向上技術の創出やユーザインターフェースの改良を実現できたことから運用を終了。2012年12月17日から音声翻訳の技術はFEAT(http://www.feat-ltd.jp/![]() )にライセンスし、「VoiceTra+」として同機能の無料アプリを開始している。また、更なる高度化を進めるため、23ヵ国26の研究機関が参加する国際的な枠組みU-STAR(the Universal Speech Translation Advanced Research consortium)が設立され、27言語(音声入力17言語、音声出力14言語)の翻訳が可能な「VoiceTra4U」を無料で提供中。http://www.nict.go.jp/press/2012/12/18-1.html

)にライセンスし、「VoiceTra+」として同機能の無料アプリを開始している。また、更なる高度化を進めるため、23ヵ国26の研究機関が参加する国際的な枠組みU-STAR(the Universal Speech Translation Advanced Research consortium)が設立され、27言語(音声入力17言語、音声出力14言語)の翻訳が可能な「VoiceTra4U」を無料で提供中。http://www.nict.go.jp/press/2012/12/18-1.html![]()

29 International Workshop on Spoken Language Translation

30 独立行政法人情報通信研究機構、「NICTユニバーサルコミュニケーション研究所の音声処理・多言語翻訳技術」、2014年1月(総務省スマートテレビ時代の字幕等の在り方に関する検討会)

31 その後「Tag Suggestions」の自動でタグを付ける機能はプライバシーの観点から変更された。

32 Yaniv Taigman, Ming Yang, Marc'Aurelio Ranzato, Lior Wolf, “DeepFace: Closing the Gap to Human-Level Performance in Face Verification”, Mar. 2014

33 https://www.facebook.com/publications/546316888800776/![]()

34 OTT=Over the Topの略。自社では通信ネットワークは持たずにコンテンツ等を配信する上位産業レイヤーを指し、代表的なものにスマートフォンアプリ企業等がある。

35 IBMのダーメンドラ・モジャ氏が2008年のSingularity Summitで語ったところによると、2018年には38.5ぺタFLOPSの能力を誇る人間の脳のシミュレーションを行うことができるようになると予想している

36 Michael Driscoll氏(Metamarkets CEO)資料

http://strata.oreilly.com/2011/08/building-data-startups.html![]()

37 米国IBM, “http://www-06.ibm.com/ibm/jp/about/ibmtopics/year_1997.html![]()

38 Top500.org, “http://www.top500.org/list/2011/06/?page=2![]() ”, Jun. 2011

”, Jun. 2011

39 http://www-06.ibm.com/ibm/jp/lead/ideasfromibm/watson/![]()

40 日本将棋連盟、””、2014年4月

41 サードウェーブデジノス、”http://www.dospara.co.jp/5gamepc/cts_denou![]() ”

”

42 Artificial Intelligence

43 Intelligence Amplification

44 The Dartmouth Summer Research Project on Artificial Intelligence

45 人工知能学会、“http://www.ai-gakkai.or.jp/whatsai/AItopics5.html![]()

46 エキスパート・システムは1970代後半に開発された、プログラムで課題対応のアルゴリズムを考えるのではなく、各産業分野における専門家の知識と考え方をコンピューターに移植したシステム。1980年代に盛んになった時期もあったが、プログラム化できないルール等で矛盾が生じる場合もあったことから、その後の主流とはならなかった。

47 ニューラル・ネットワークはAIが提唱された初期から研究されていたが、他の手法が効率が良かった等の背景から長年主流にはならなかった。

48 スパース・オートエンコーダと呼ばれる

49 10億のパラメータ×9層のニューラル・ネットワークをコア数16,000で処理

50 Google Official Blog, http://googleblog.blogspot.jp/2012/06/using-large-scale-brain-simulations-for.html![]() Jun. 2012

Jun. 2012

51 http://googleblog.blogspot.jp/2012/06/using-large-scale-brain-simulations-for.html![]()

52 http://www.darpa.mil/NewsEvents/Releases/2013/12/16.aspx![]()

53 2014年12月に本戦開催が予定されている

54 DRC(DARPA)、””、2003)

55 http://www.darpa.mil/NewsEvents/Releases/2014/03/21.aspx![]()

56 http://www.cyberdyne.jp/products/LowerLimb_medical.html![]()

57 Kaggle社Merck Molecular Activity Challenge “https://www.kaggle.com/c/MerckActivity![]() ” 及び “http://blog.kaggle.com/2012/11/01/deep-learning-how-i-did-it-merck-1st-place-interview/

” 及び “http://blog.kaggle.com/2012/11/01/deep-learning-how-i-did-it-merck-1st-place-interview/![]() ”, Nov. 2012

”, Nov. 2012

58 Numenta,

59 http://www.yano.co.jp/press/pdf/1196.pdf![]()