1 生成AIが抱える課題

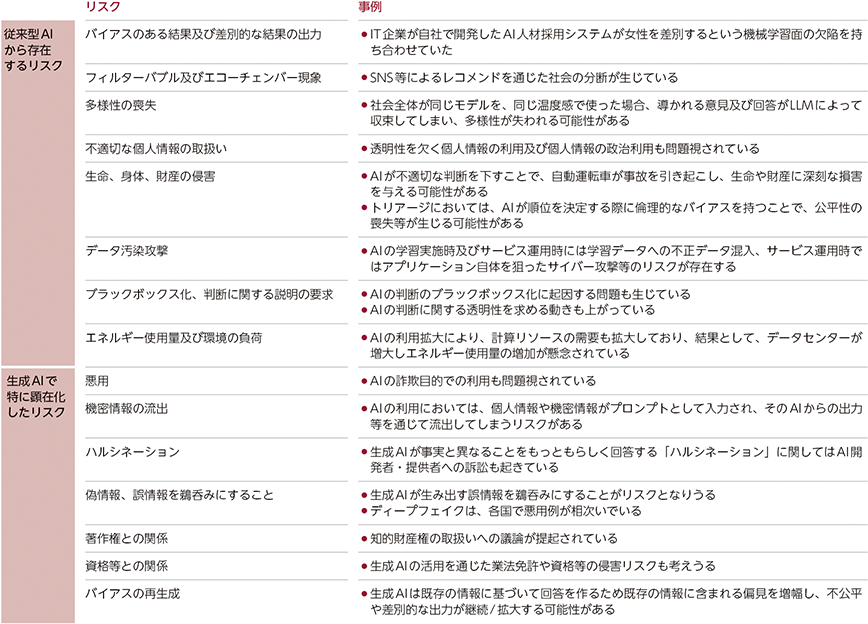

2024年4月に総務省・経済産業省が策定した「AI事業者ガイドライン(第1.0版)」では、(従来から存在する)AIによるリスクに加えて、生成AIによって顕在化したリスクについて例示している(図表Ⅰ-4-1-1)。例えば、従来から存在するAIによるリスクとして、バイアスのある結果及び差別的な結果が出力されてしまう、フィルターバブル及びエコーチェンバー現象1が生じてしまう、データ汚染攻撃のリスク(AIの学習実施時の性能劣化及び誤分類につながるような学習データの混入等)、AIの利用拡大に伴う計算リソースの拡大によるエネルギー使用量及び環境負荷2等が挙げられている。また、生成AIによって顕在化したリスクとしては、ハルシネーション等が挙げられる。生成AIは事実に基づかない誤った情報をもっともらしく生成することがあり、これをハルシネーション(幻覚)と呼ぶ。技術的な対策が検討されているものの完全に抑制できるものではないため、生成AIを活用する際には、ハルシネーションが起こる可能性を念頭に置き、検索を併用するなど、ユーザーは生成AIの出力した答えが正しいかどうかを確認することが望ましい。また、生成AIの利用において、個人情報や機密情報がプロンプトとして入力され、そのAIからの出力等を通じて流出してしまうリスクや、ディープフェイクによる偽画像及び偽動画といった偽・誤情報を鵜呑みにしてしまい、情報操作や世論工作に使われるといったリスク、既存の情報に基づいてAIにより生成された回答を鵜呑みにする状況が続くと、既存の情報に含まれる偏見を増幅し、不公平あるいは差別的な出力が継続/拡大する(バイアスを再生成する)リスクがあること等も指摘されている。

同ガイドラインでは、このような「リスクの存在を理由として直ちにAIの開発・提供・利用を妨げるものではない」としたうえで、「リスクを認識し、リスクの許容性及び便益とのバランスを検討したうえで、積極的にAIの開発・提供・利用を行うことを通じて、競争力の強化、価値の創出、ひいてはイノベーションに繋げることが期待される」としている。

1 「フィルターバブル」とは、アルゴリズムがネット利用者個人の検索履歴やクリック履歴を分析し学習することで、個々のユーザーにとっては望むと望まざるとにかかわらず見たい情報が優先的に表示され、利用者の観点に合わない情報からは隔離され、自身の考え方や価値観の「バブル(泡)」の中に孤立するという情報環境を指す。「エコーチェンバー」とは、同じ意見を持つ人々が集まり、自分たちの意見を強化し合うことで、自分の意見を間違いないものと信じ込み、多様な視点に触れることができなくなってしまう現象を指す。これらへの対応については、第6章第1節2.参照

2 同ガイドラインにおいては、エネルギー管理にAIを導入することで、効率的な電力利用も可能となる等、AIによる環境への貢献可能性もある点も指摘されている。